Đằng sau những tiêu đề về cách ChatGPT đang thay đổi thế giới là một con chip chủ lực do một công ty trước đây chỉ được chủ yếu biết đến với thẻ đồ họa (cho máy điện toán).

Công ty Nvidia là người chiến thắng lớn lao nhất khi nói đến phần cứng; giá cổ phiếu của nó đã tăng gần gấp đôi kể từ giữa tháng 10 năm 2022 khi những lời bàn tán xung quanh OpenAI và ChatGPT bắt đầu nổi lên; Điều này đã thúc đẩy sự gia tăng lớn về nhu cầu truy cập ChatGPT và phần cứng chuyên dụng giúp công nghệ này trở nên cần kíp và nó không hề có giá rẻ chút nào.

Điều này phần nào giải thích tại sao NVdia có giá trị vốn hóa thị trường lên tới 556 tỷ USD vào thời điểm viết bài này, công ty làm thẻ đồ họa Geforce, một cái tên quen thuộc bỗng chốc, nay lại có giá trị hơn cả vốn của hãng Arm, Intel, IBM và AMD cộng lại.

Chip A100 là gì?

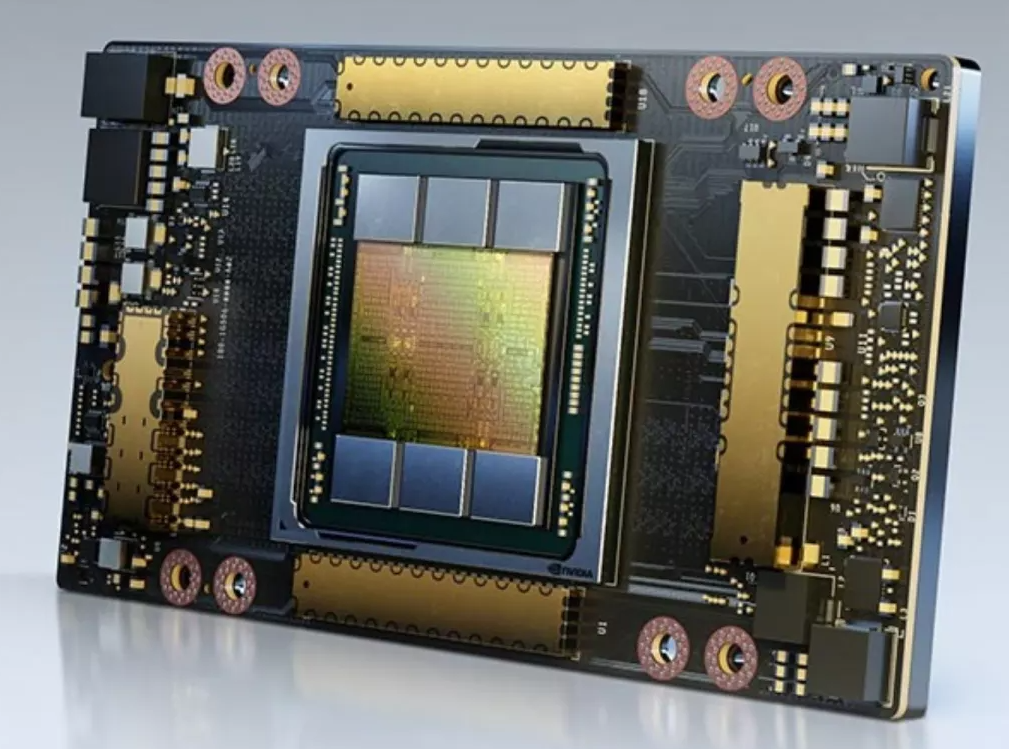

Có thể nói một phần công nghệ duy nhất đang giúp ChatGPT hoạt động chính là bộ tăng tốc A100 HPC (máy tính hiệu năng cao). Đây là GPU lõi tensor trị giá 12.500 đô la , có bộ nhớ HBM2 hiệu suất cao (80GB) có khả năng cung cấp băng thông bộ nhớ lên tới 2TBps, đủ để chạy các mô hình và bộ dữ liệu rất lớn.

Ấn tượng hơn, nó làm mát thụ động – mặc dù có TDP 300W – nhưng yêu cầu hai khe cắm để chứa tản nhiệt lớn cho phiên bản PCIe. Nó dựa trên vi kiến trúc Ampere 3 năm tuổi, là thứ cung cấp năng lượng cho toàn bộ GPU Geforce trong sê-ri 30 (và RTX 2050 – có trong Honor MagicBook 14 – và MX570 ).

A100 thường được tìm thấy trong gói tám chiếc chip, đó là những gì Nvidia đưa vào DGX A100, hệ thống AI phổ quát của riêng họ có giá nhãn dán là 199.000 USD. Serveathome đã xuất bản một số hình ảnh cận cảnh của A100 có tạo hình đặc biệt gọi là SXM4 cho phép thiết lập kích cỡ nhỏ gọn hơn nhiều, nó giúp cho các nhà tích hợp hệ thống có thể đặt để nhiều bộ phận này hơn trên mỗi đơn vị dung lượng, cũng như hiệu suất cao hơn nhờ TDP cao hơn (400W cho kiểu máy đó).

Hãy sẵn sàng cho ChatGPT 4.5 và hơn thế nữa

Chúng ta đã biết điều gì sẽ đến sau A100 – H100, dựa trên kiến trúc Hopper GPU , chạy song song, Ada Lovelace (chính là thứ cung cấp năng lượng cho RTX 4090 ). Ra mắt vào năm 2022, nó sử dụng hệ số hình thức mới (SXM5), có nhiều băng thông bộ nhớ hơn (3TBps) và nhanh hơn nhiều so với phiên bản tiền nhiệm. Nvidia nói rằng nó có thể đáp ứng quy trình AI nhanh hơn tới 9 lần so với A100 hay nói cách khác, trong khối lượng công việc cụ thể, nó có thể thay thế chín thẻ A100.

Tuy nhiên, tất cả những điều đó đều phải trả giá; vì GPU mới có TDP (700W) cao hơn nhiều và gần như chắc chắn sẽ yêu cầu tản nhiệt lớn hơn và có khả năng phải làm mát bằng chất lỏng (cái mà Serveathome gọi là ngâm trực tiếp cửa sau của chip ) để duy trì sự ổn định và hiệu suất. Ngoài ra còn có chi phí thực tế của mặt hàng: NV-H10-80 có giá khủng lên đến 32.000 đô la (ed: Điều đó dường như không ngăn được Oracle hoặc Microsoft mua hàng chục nghìn chiếc).

Các phiên bản của HGX- H100 – phiên bản thay thế HGX-A100 và sẽ là nền tảng phần cứng của các máy biến áp được tạo cho thế hệ máy mới trong tương lai – sẽ được cho thuê trên CoreWeave và Lambdalabs từ tháng 3 năm 2023, thoạt đầu dịch vụ dựa trên máy làm theo phiên bản cũ, giá thuê chỉ từ $2,23 mỗi giờ khi thuê bao công suất đặt trước, như một dịch vụ cho thuê máy tính. Ngoài ra, bạn có thể muốn có hệ thống H100 tùy chỉnh, đặt làm riêng cho mình từ các nhà tích hợp hệ thống chuyên nghiệp như Silicon Mechanics , Microway hoặc Dell với giá từ dưới 300.000 USD.

Khởi đầu mạnh mẽ của Nvidia trong lĩnh vực máy gia tốc GPU đã bỏ xa các đối thủ của nó, AMD và Intel , cho phép công ty Mỹ này tiến về phía trước và có thể trở thành công ty bán dẫn nghìn tỷ đô la đầu tiên.

Mọi chuyện sẽ còn thú vị hơn nữa khi con Superchip tên là Grace ra đời, dựa trên công nghệ chip của ARM và Hopper con chip GPU khổng lồ của NVdia, cả hai thứ này hợp lực lại với nhau.

Lời bàn:

Không biết có vẫn còn kịp thời để làm giầu bằng cách mua cổ phiếu của NVdia?

Phan Sinh Trần